还在傻傻的折腾半天 Ollama 安装 deepseek-r1?ServBay 1.9 一键安装各大模型

还在为反复折腾 Ollama 安装命令、配置环境变量而头疼?ServBay 1.9 的发布,彻底改变了本地 AI 模型部署的复杂流程。这款原本以“3分钟搭建 Web 开发环境”著称的工具,如今通过集成大模型管理功能,将一键式极简理念扩展至 AI 领域,成为开发者的全能助手。

一、传统方式部署 DeepSeek-R1 的痛点

以部署 DeepSeek-R1 为例,传统流程需依赖 Ollama 工具,步骤繁琐:

环境配置:需手动安装 Ollama,调整模型存储路径(如修改 Windows 环境变量

OLLAMA_MODELS),甚至需科学上网下载安装包;命令行操作:通过

ollama run deepseek-r1:8b等命令下载模型,对新手极不友好;可视化界面依赖:需额外安装 Chatbox 等工具,并配置 API 连接参数;

资源占用高:模型运行需较高硬件配置(如 GPU 版本要求 RTX 2060 以上显卡),调试过程易因内存不足卡顿。

二、ServBay 1.9 的颠覆性革新

ServBay 1.9 将 AI 模型部署与开发环境管理深度融合,实现“开箱即用”:

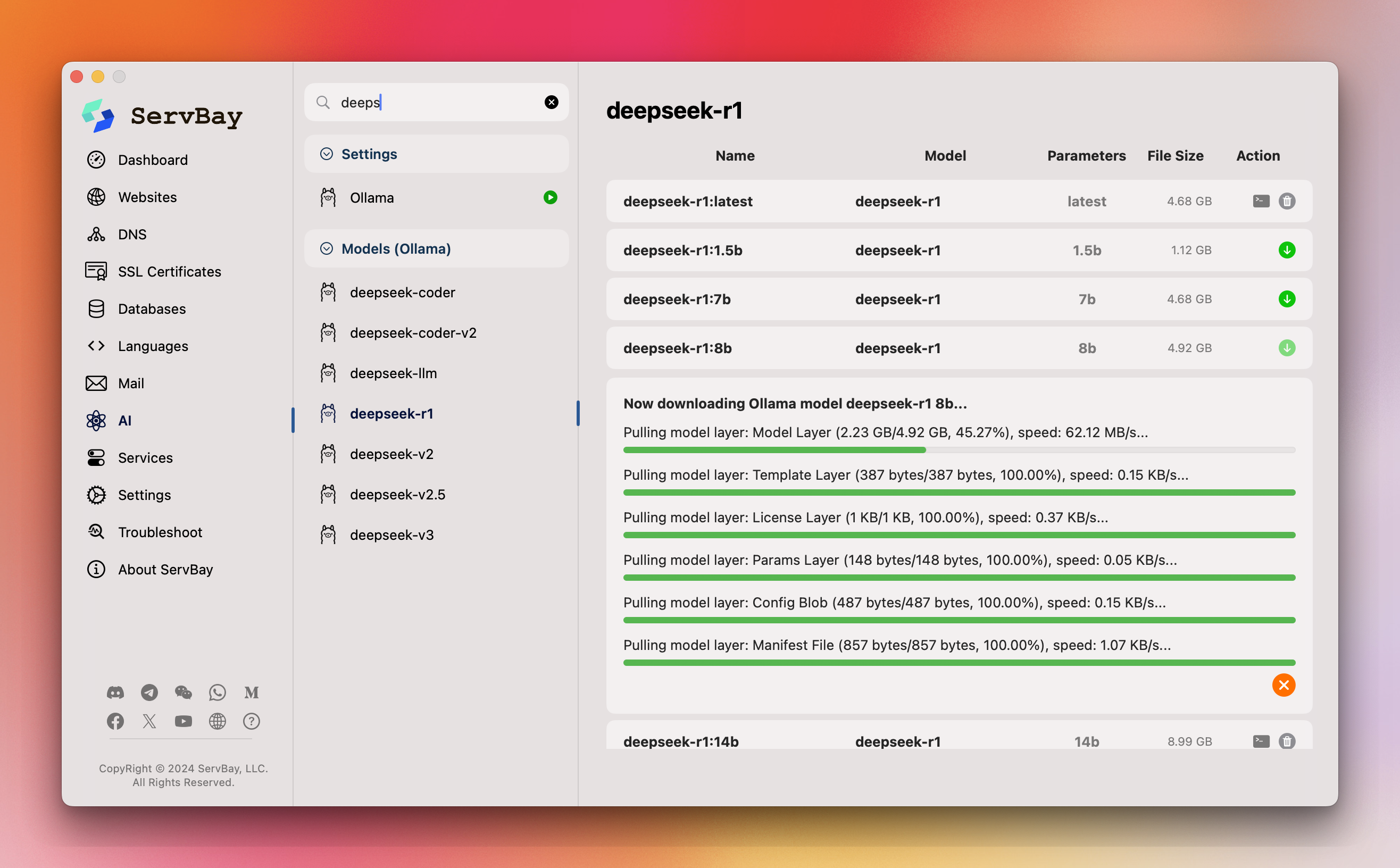

一键安装模型

内置模型库支持 DeepSeek-R1、Llama 3 等主流大模型,用户仅需在图形界面勾选所需版本(如 1.5B、8B、671B),点击安装即可自动完成依赖配置与资源分配,无需手动输入命令。资源智能管理

结合容器化技术,动态分配 CPU/GPU 资源,优化显存占用。例如,运行 8B 模型时自动启用 GPU 加速,避免传统方式因配置不当导致的性能浪费。无缝集成开发环境

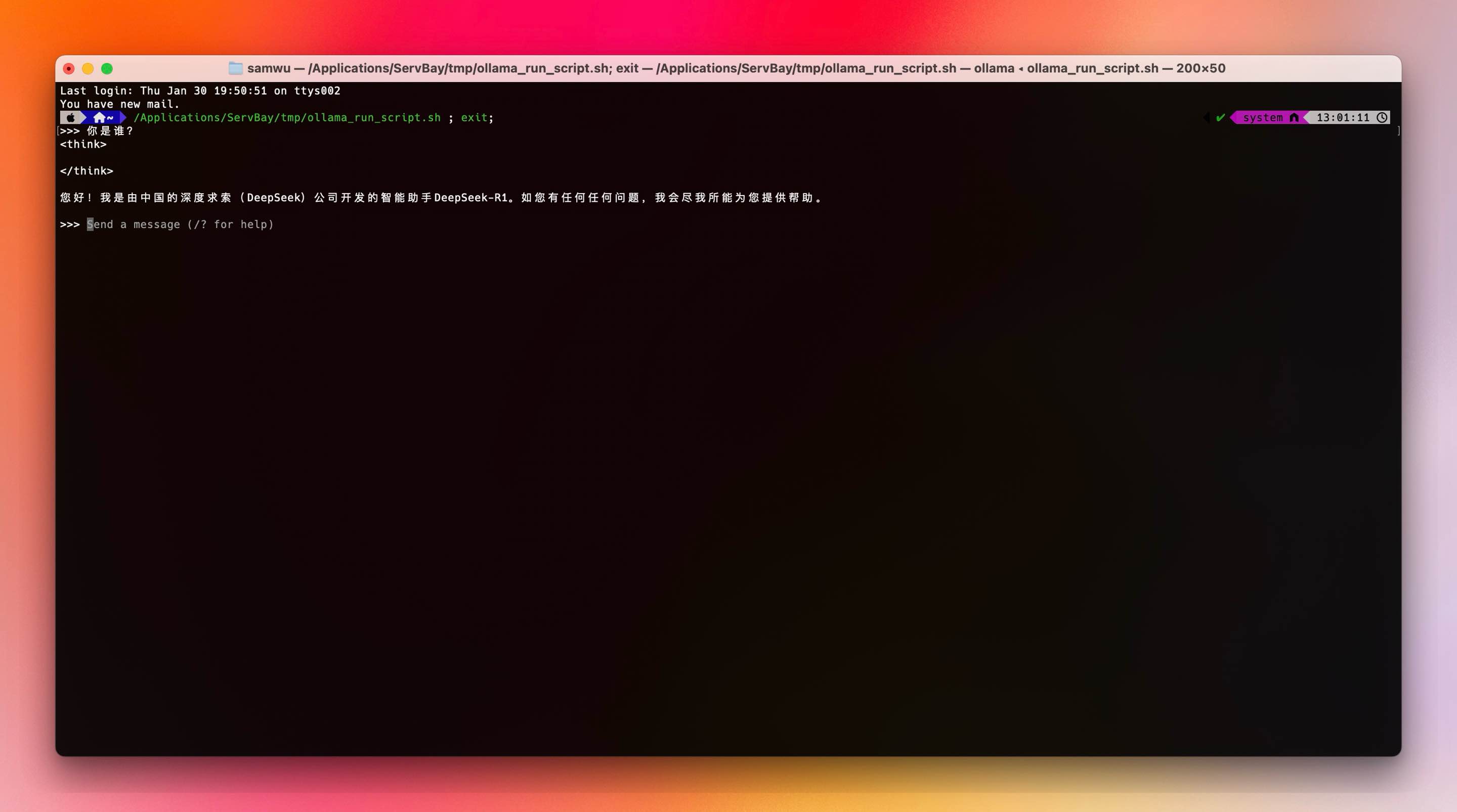

支持在本地 Web 服务中直接调用模型 API。例如,通过 ServBay 预装的 Node.js 环境快速搭建 GraphQL 服务,结合 Apollo Server 实现与大模型的交互,开发者可专注于业务逻辑而非环境调试。可视化监控与调试

提供实时资源监控面板,显示模型运行时的内存、显存及算力消耗,并内置日志分析工具,快速定位响应延迟或报错问题。

三、ServBay vs Ollama:效率与体验的全面碾压

| 对比维度 | Ollama 传统部署 | ServBay 1.9 |

|---|---|---|

| 安装复杂度 | 需手动配置环境变量、依赖库 | 全自动安装,无需额外操作 |

| 资源管理 | 依赖命令行参数调整,易出错 | 图形化资源分配,智能优化 |

| 多模型支持 | 需逐一下载,版本切换繁琐 | 统一管理界面,支持多版本共存与一键切换 |

| 开发整合 | 需独立配置 API 网关 | 内嵌反向代理,直接绑定域名与 SSL 证书 |

| 硬件适配 | GPU 加速需手动启用 | 自动检测硬件,动态启用加速 |

四、应用场景:从开发到部署的全链路提效

本地 AI 助手集成

结合 ServBay 的 PHP/Node.js 环境,开发者可快速搭建智能客服系统。例如,通过调用 DeepSeek-R1 的推理 API,实现用户问题的自动归类与解答,同时利用 ServBay 的 MySQL 数据库管理工具存储对话日志。私有化模型微调

支持导入自定义数据集,利用 ServBay 的 Docker 集成功能创建隔离训练环境,避免污染本地开发配置。完成后可直接将模型封装为服务,通过统一面板发布。教育与实验

学生或研究者可一键部署不同规模的模型(如从 1.5B 到 671B),对比性能差异,而无需担心环境冲突或依赖缺失。

五、未来展望:AI 平民化的关键推手

ServBay 的升级标志着开发工具正从“环境配置者”向“能力聚合者”进化。其价值不仅在于简化部署流程,更在于降低技术门槛,让开发者专注于创新而非运维。随着多模态模型的支持扩展(如文生视频工具 Video Ocean 的集成),ServBay 有望成为连接开发、测试与 AI 应用的核心平台。

立即行动:访问 ServBay 官网 下载 1.9 版本